فایل robots.txt چیست و چگونه سئوی سایت را متحول میکند؟

مدت زمان مطالعه : 10 دقیقه

مدت زمان مطالعه : 10 دقیقه  0 کامنت

0 کامنتوقتی وارد دنیای سئو میشیم خیلی ها robots.txt رو فقط یه فایل ساده برای بستن چند مسیر میدونن اما حقیقت اینه که robots.txt خیلی بیشتر از این حرفاست؛ یه ابزار استراتژیکه که میتونه مسیر رشد سایتت رو مدیریت کنه و حتی روی رتبه ات توی نتایج جستجو تاثیر بذاره.

تصور کن سایتت یه شهر بزرگه و ربات های موتور جستجو مثل توریست هایی هستن که تو خیابون ها می چرخن. این فایل مثل یه نقشه هوشمنده که نشون میده کدوم مسیر ها ارزش دیدن دارن و کدوم ها فقط وقت تلف می کنن.

حالا اگه می خوای بدونی چطور می تونی از این فایل ساده یه ابزار قدرتمند سئو بسازی، ادامه مقاله رو بخون!

فایل robots.txt چیست؟

فایل Robots.txt یه فایل متنی ساده است که تو ریشه سایت قرار می گیره و به موتور های جستجو میگه که کدوم صفحات یا پوشه ها رو نباید خزش کنن. یعنی با این فایل می تونی کنترل کنی ربات ها کجا برن و کجا نرن.

مثلاً فرض کن یه سایت فروشگاهی داری و یه سری صفحات آزمایشی یا صفحات ورود کاربر داری که نمی خوای تو گوگل دیده بشن. با فایل Robots.txt می تونی مسیر اون صفحات رو مسدود کنی بدون اینکه مجبور باشی حذفشون کنی .

همچنین این فایل کمک می کنه تا بودجه خزیدن (Crawl Budget) سایتت بهتر مدیریت بشه. یعنی ربات های گوگل وقت و منابعشون رو صرف صفحات مهمتر کنن و روی صفحات کم اهمیت وقت تلف نکنن.

چرا robots.txt فقط یه فایل ساده نیست؟

- مدیریت بودجه خزیدن (Crawl Budget):

گوگل منابع محدودی برای هر سایت در نظر می گیره. اگه این منابع صرف صفحات تکراری یا کم اهمیت بشن، صفحات کلیدی نادیده گرفته میشن. این قایل اینجا نقش یه فیلتر هوشمند رو بازی می کنه - تقویت سیگنال های سئو:

فقط جلوگیری از خزش کافی نیست. وقتی با Disallow صفحات فرعی رو مسدود می کنی و همزمان با تگ Canonical صفحات اصلی رو تقویت می کنی، در واقع داری به گوگل جهت میدی که انرژی ایندکس رو روی محتوای باارزش متمرکز کنه - کنترل استراتژیک محتوا:

بعضی محتواها مثل فایل های سنگین، بخش های تکراری یا API ها نه تنها ارزش سئو ندارن، بلکه می تونن به تجربه کاربری هم ضربه بزنن. این فایل بهت اجازه میده این ریسک ها رو مدیریت کنی بدون اینکه ساختار سایت رو تغییر بدی

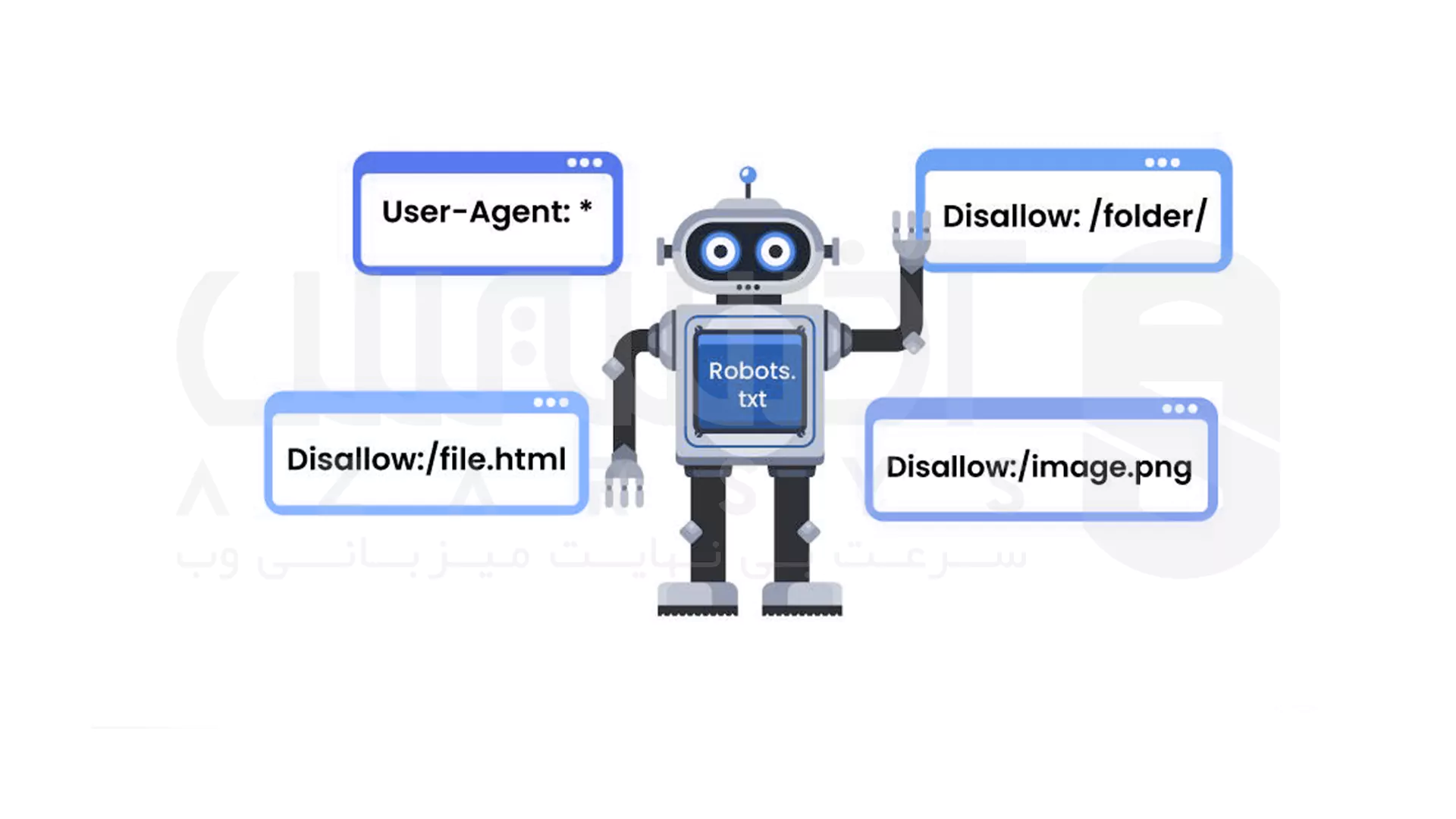

🛠 دستورات رایج در فایل robots.txt

ساختار فایل خیلی ساده است:

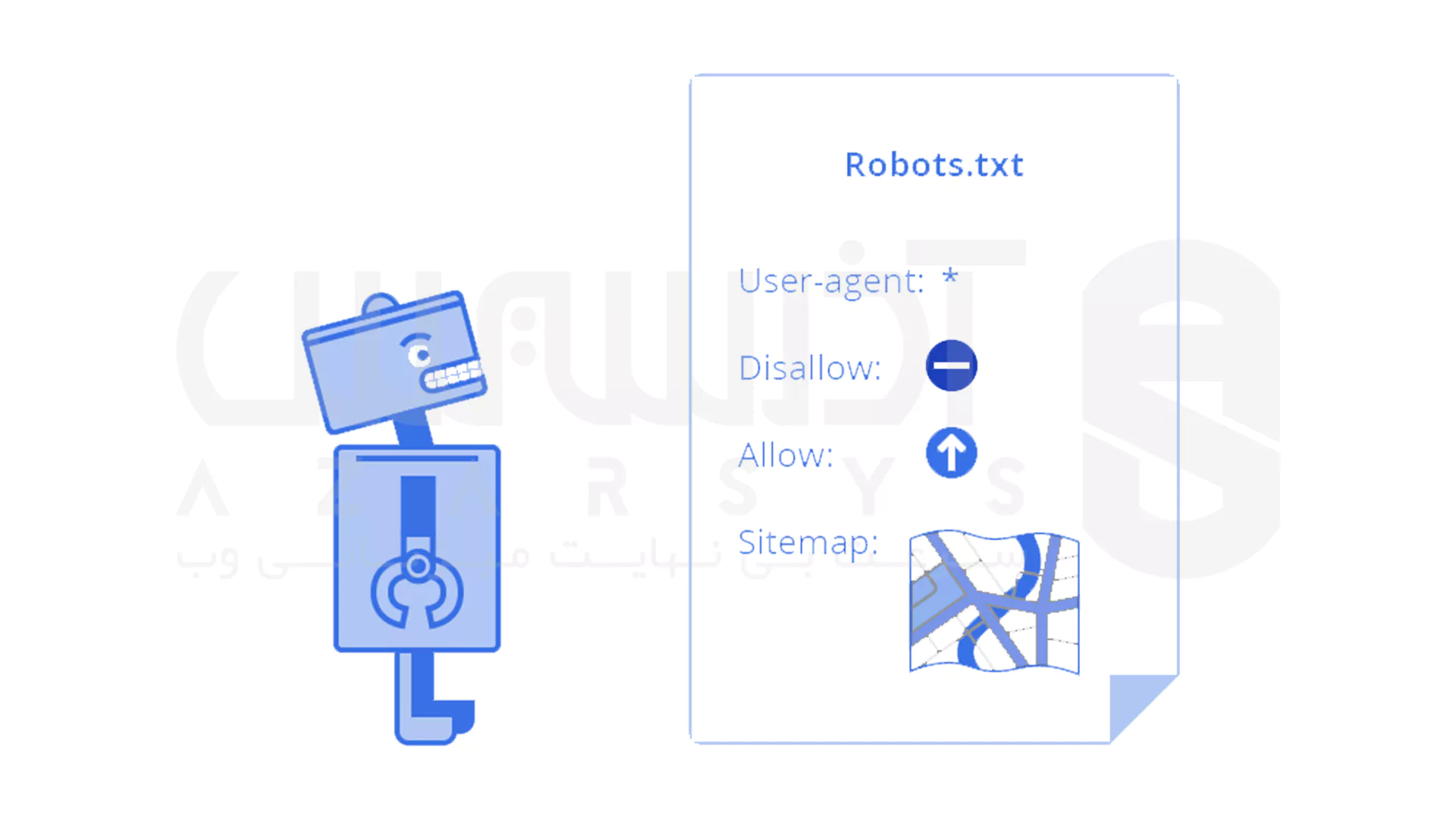

User-agent: [نام ربات] Disallow: [مسیر مسدود شده] Allow: [مسیر مجاز] Sitemap: [آدرس نقشه سایت]

مثال عملی:

User-agent: * Disallow: /private/ Allow: /private/public-page.html Sitemap: https://example.com/sitemap.xml

- User-agent: *: یعنی دستور برای همه ربات ها

- Disallow: /private/: مسیرهای خصوصی یا کم اهمیت مسدود شدن

- Allow: مسیرهایی که هنوز میخوای خزیده بشن

- Sitemap: کمک می کنه ربات ها راحت تر صفحات مهم سایتت رو پیدا کنن

نکته حرفه ای: می تونی برای ربات های خاص مثل Googlebot یا Bingbot دستور خاص بذاری تا کنترل دقیق تری روی خزیدن داشته باشی.

خطاهای رایج (و راه حل های حرفه ای)

اعتماد بیش از حد به robots.txt:

بستن صفحه با Disallow لزوماً به معنای حذف اون از نتایج نیست. برای حذف کامل، باید noindex یا ابزار Remove گوگل استفاده بشه.مسدود کردن منابع حیاتی:

بعضی ها CSS و JS رو می بندن چون فکر می کنن مهم نیست. اما گوگل برای درک تجربه کاربری به این فایل ها نیاز داره.بی توجهی به تغییرات سایت:

هر بار که ساختار URL یا مسیر ها تغییر می کنه، robots.txt باید بازبینی بشه. وگرنه ربات ها سرگردان میشن.

نکات حرفه ای و استراتژیک

ترکیب با متا تگ noindex:

Robots.txt جلوی خزش رو میگیره، ولی صفحات ممکنه هنوز ایندکس بشن. ترکیب با noindex بهترین نتیجه رو میده

مدیریت محتوای تکراری و کم ارزش:

با Disallow صفحات تکراری رو مسدود کن تا رتبه صفحات اصلی حفظ بشه، بدون اینکه مجبور به حذف کامل باشی

بهینه کردن سرعت و منابع سرور:

جلوی خزش صفحات سنگین یا کم اهمیت رو بگیر تا فشار روی سرور کم بشه و تجربه کاربری بهتر بشه

اولویت دهی و بودجه خزیدن سایت های بزرگ:

برای سایت های بزرگ، تعیین مسیرهای مجاز و مسدود شده باعث میشه ربات ها بیشتر روی صفحات کلیدی تمرکز کنن

کنترل منابع حساس و API ها

می تونی جلوی خزیدن فایل های JS/CSS خاص یا API ها رو بگیری تا تجربه کاربری و رتبه بندی تحت تاثیر قرار نگیره

مثال واقعی: سایت خبری با هزاران مقاله میتونه با Disallow کردن صفحات آرشیو یا برچسب های کم اهمیت، ربات ها رو به صفحات پربازدید هدایت کنه.

ابزارهای تست و بررسی

می خوای مطمئن شی فایل درست کار می کنه؟ این ابزارها کمک می کنن:

- Google Search Console: بخش “robots.txt Tester”

- Screaming Frog SEO Spider: شبیه سازی رفتار ربات ها و بررسی صفحات مسدود شده

نکته حرفه ای: بعد از تنظیم فایل، هر چند وقت یه بار تستش کن تا مطمئن شی با تغییرات سایت دستوراتش از کار نیفتاده.

🔄 تفاوت با متا تگ noindex

- robots.txt: جلوگیری از خزش صفحات

نکته حرفه ای: فقط جلوی خزش رو میگیره، ایندکس ممکنه ادامه پیدا کنه.

- متا تگ noindex: جلوگیری از ایندکس شدن صفحات

نکته حرفه ای: صفحات خزیده میشن اما تو نتایج نشون داده نمیشن.

برای کنترل کامل سایت، بهتره هر دو روش رو با هم استفاده کنی.

جمع بندی

robots.txt یه چاقوی جراحی سئوئه. اگه درست استفاده بشه، بودجه خزیدن رو بهینه می کنه، محتوای کلیدی رو تقویت می کنه و تجربه کاربری رو بالا می بره اما اگه سطحی یا اشتباه تنظیم بشه، می تونه باعث حذف ناخواسته صفحات ارزشمند بشه.

بنابراین به جای دیدن robots.txt بهعنوان یه فایل ساده متنی، باید بهش به چشم یه استراتژی مدیریت منابع و قدرت سئو نگاه کرد.

اگه دوست داری بیشتر با سئو و تکنیک های حرفه ای مدیریت سایت آشنا بشی، می تونی سری به مقالات سئو وبسایت آذرسیس بزنی و نکات کاربردی بیشتری یاد بگیری.

به معنای مسدود کردن کل سایت برای ربات مورد نظر است.

ستاره (*) یعنی تمام ربات ها. می توانید دستورات را فقط برای یک ربات خاص مثل Googlebot یا Bingbot اعمال کنید.

خیر. اکثر رباتهای معتبر مثل گوگل، بینگ و یاهو به آن احترام می گذارند، اما ربات های مخرب یا اسپم ممکن است آن را نادیده بگیرند.