مدت زمان مطالعه : 0 دقیقه

مدت زمان مطالعه : 0 دقیقه ۰ کامنت

۰ کامنتموتور های جستجو همیشه در حال خزیدن و ایندکس کردن صفحات ایجاد شده در سایت ها از طرف ما هستند. این کار ممکن است در یک زمان طولانی انجام شود.

به همین دلیل، برای اینکه به گوگل و دیگر موتور های جستجو یک راه میان بر نشان دهیم، می توانیم از ایجاد فایل Robots.txt روی سرور خود کمک بگیریم.

فایل Robots.txt یکی از ساده ترین فایل های متنی برای وب سایت است، اما تنها یک کاراکتر اشتباه برای خراب کردن سئو شما کافی خواهد بود.

این فایل دستورالعملهایی برای روبات موتور جستجو است، که به آنها میگوید کدام صفحات را باید و کدام صفحات نباید خزیده شوند.

دلایل اهمیت ایجاد فایل Robots.txt

فایل Robots.txt به هدف دهی فعالیت یک خزنده در وب سایت شما کمک میکند، اما دلایل دیگری برای ساخت این فایل نیز وجود دارد که در قسمت زیر به آن اشاره می کنیم.

بهینه سازی Crawl Budget

Crawl Budget همان تعداد صفحاتی است، که Google در یک زمان در سایت میخزد. این تعداد می تواند بر اساس اندازه، سلامت و بک لینک سایت تان متفاوت باشد.

Crawl Budget به این دلیل مهم است، که اگر تعداد صفحات شما بیشتر از Crawl Budget سایت شما باشد، قطعاً صفحاتی در سایت وجود خواهند داشت، که ایندکس نشده باقی بمانند.

با مسدود کردن خزیدن در صفحات غیرضروری می توان رتبه بندی صفحات مهم را بهتر کرد.

- مسدود کردن صفحات تکراری و غیر عمومی

همه صفحات ما نیاز به ایندکس شدن و رتبه بندی ندارند، بنابراین لازم نیست اجازه خزیدن تمامی صفحه ها را به موتور جستجو بدهیم.

برای مثال ممکن است یک سایت لوازم آرایشی داشته باشید، و بخواهید که فیلترهایی در مثل ارزان ترین محصول ایجاد کنید. دراین حالت با ایجاد فایل Robots.txt می توانید از نمایش برخی صفحات جلوگیری کنید.

مخفی کردن منابع

گاهی اوقات می خواهیم که Google منابع مانند PDF، ویدیوها و تصاویر را از نتایج جستجو حذف کند. زیرا ممکن است بخواهیم آن منابع را خصوصی باشد، یا تمرکز گوگل را روی محتوای مهم تر قرار گیرد.

در این صورت نیز استفاده از فایل robots.txt بهترین راه برای جلوگیری از ایندکس شدن آنهاست.

فایل Robots.txt چگونه کار می کند؟

این فایل به ربات موتور جستجوگر میگوید، که در کدام URL میتواند بخزد. در واقع موتورهای جستجو دو کار اصلی دارند:

- خزیدن در سایت برای کشف محتوا

- ایندکس کردن محتوا جهت نشان دادن آن به کاربری که به دنبال اطلاعات است.

در حین خزیدن، ربات های موتور جستجو لینک ها را کشف کرده و دنبال می کنند. این فرآیند آنها را از سایت A به سایت B به سایت C و میلیاردها لینک و وب سایت می برد.

پس از ورود یک ربات به سایتی اولین کاری که انجام می دهد، این است که به دنبال فایل robots.txt آن می گردد. در صورت یافتن آن قبل از انجام هر کار دیگری، فایل را می خواند.

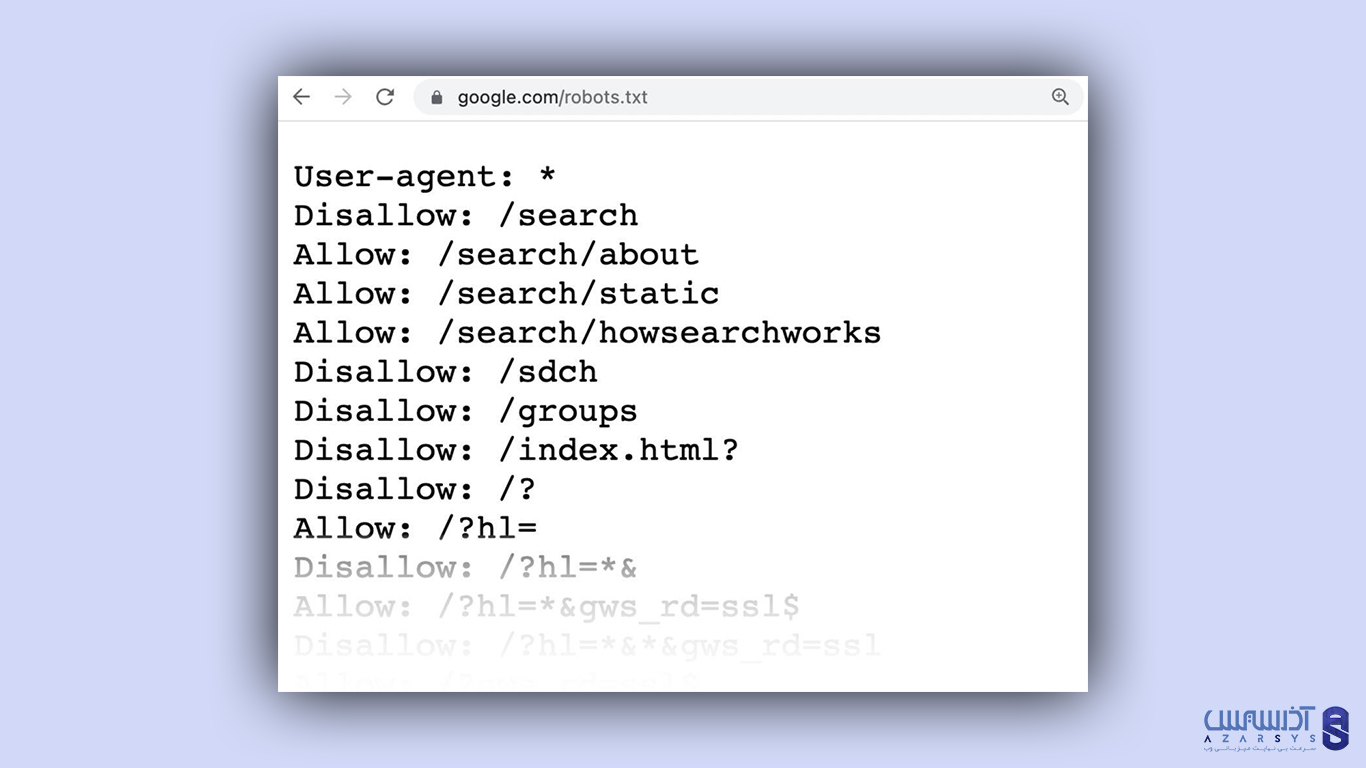

برای مثال نمونه یک فایل robots.txt به شکل زیر است:

در فایل هایی که ایجاد می کنیم، میتوانیم از علامت ستاره (*) جهت اختصاص دستورالعملها برای هر کاربر استفاده کنیم. به این معنی، که برای همه ربات ها اعمال می شود.

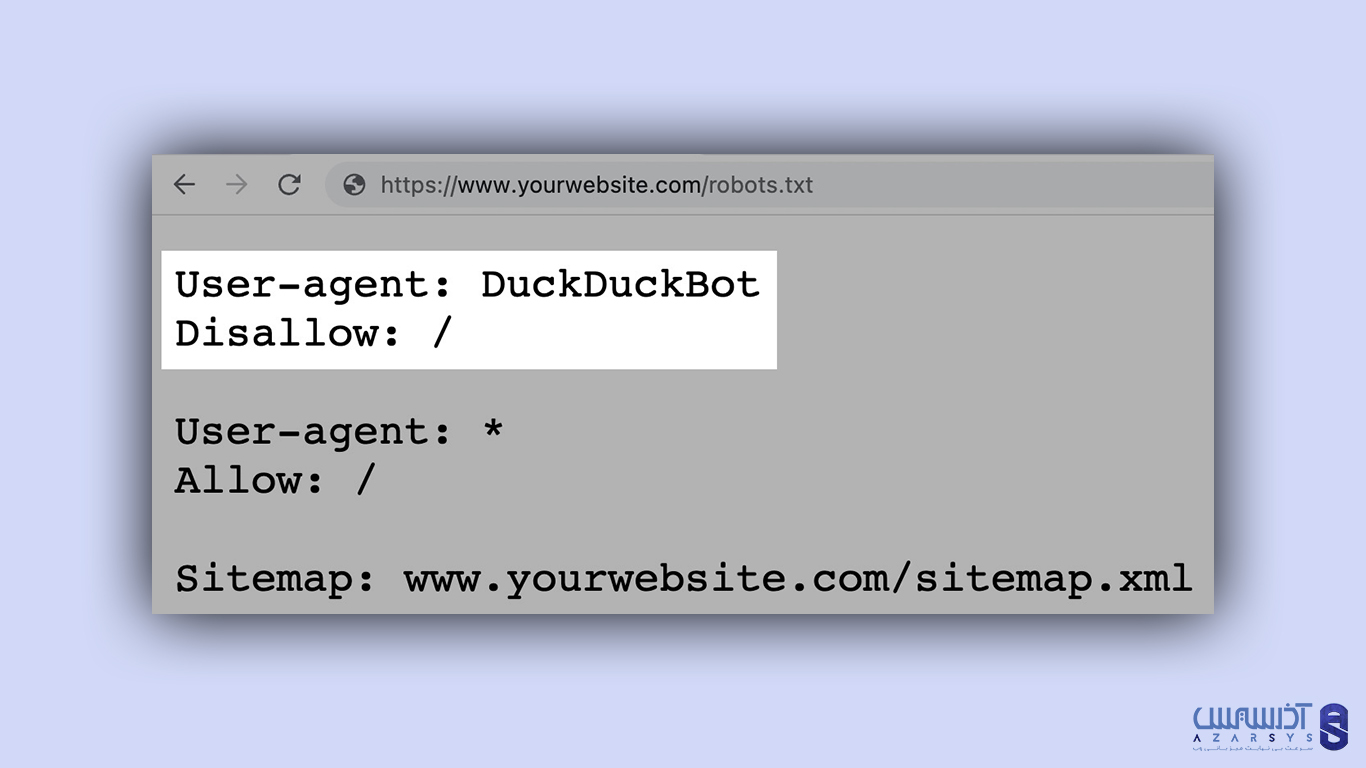

برای مثال، اگر بخواهید به همه ربات ها به جز DuckDuckGo اجازه خرش در سایتتان را بدهید ، دستورالعمل زیر اجرا خواهد شد:

بهترین روش های ایجاد فایل Robots.txt

هنگام ایجاد کردن فایل Robots.txt برای جلوگیری از اشتباهات رایج، شیوه های زیر را در ذهن داشته باشید.

- از خطوط جدید برای هر دستورالعمل استفاده کنید.

هر سطر باید روی خط جدیدی قرار گیرد. در غیر این صورت موتور جستجو قادر به خواندن آنها نخواهند بود و دستورالعمل شما نادیده گرفته خواهد شد.

مثال غلط:

User-agent: * Disallow: /admin/

Disallow: /directory/

مثال درست:

User-agent: *

Disallow: /admin/

Disallow: /directory/

- از هر عامل کاربر فقط یک بار استفاده کنید.

رباتها اهمیتی نمیدهند که یک عامل را چندین بار وارد کنید. اما تنها یک بار ذکر آن، همه چیز را مرتب و ساده نگه می دارد و احتمال خطا را کاهش می دهد.

مثال غلط:

User-agent: Googlebot

Disallow: /example-page

User-agent: Googlebot

Disallow: /example-page-2

توجه کنید که Googlebot User-agent دو بار نوشته شده است.

مثال درست:

User-agent: Googlebot

Disallow: /example-page

Disallow: /example-page-2

در مثال اول، گوگل همچنان دستورالعمل را دنبال میکند ولی هیچ صفحهای را نمیخزد. اما، نوشتن همه دستورالعملها تحت یک عامل بهتر است و به شما در سازماندهی کمک می کند.

- از Willcards استفاده کنید.

می توانید از علامت (*) جهت اعمال یک دستور برای همه عوامل کاربر و مطابقت با الگو URL استفاده نمایید.

مثال غلط:

User-agent: *

Disallow: /shoes/vans?

Disallow: /shoes/nike?

Disallow: /shoes/adidas?

مثال درست:

User-agent: *

Disallow: /shoes/*?

مثال بالا تمامی ربات های موتور جستجو را از خزیدن همه URL ها زیر پوشه /shoes/ با علامت سوال مسدود خواهد کرد.

- از “$” برای نشان دادن پایان URL استفاده نمایید.

برای مثال، اگر می خواهید موتور جستجو را از خزیدن فایل jpg. در سایت خود مسدود کنید، می توانید آنها را به صورت جداگانه فهرست بکنید.

مثال غلط:

User-agent: *

Disallow: /photo-a.jpg

Disallow: /photo-b.jpg

Disallow: /photo-c.jpg

بهتر است از “$” استفاده کنید

مثال درست:

User-agent: *

Disallow: /*.jpg$

- از (#) برای نظرات استفاده کنید.

توسعه دهندگان اغلب از این کاراکتر برای اضافه کردن نظرات در فایل robots.txt استفاده می کنند، زیرا کمک می کند تا فایل سازماندهی شده و به راحتی خوانده شود.

برای این مورد فقط کافیست جهت اضافه کردن نظر، دستور خود را با یک هش (#) شروع کنید.

برای مثال:

User-agent: *

#Landing Pages

Disallow: /landing/

Disallow: /lp/

#Files

Disallow: /files/

Disallow: /private-files/

#Websites

Allow: /website/*

Disallow: /website/search/*

نکته: در نحوه اعمال این دستورات باید احتیاط کامل داشته باشید، زیرا همان گونه که گفته شد، فقط یک کاراکتر اشتباه ما را از مقصدمان به طور کلی دور خواهد کرد.

آذرسیس ارائه دهنده سرور های اختصاصی و سرور مجازی حرفه ای، با کیفیت بسیار بالا از 60 لوکیشن دنیا

نتیجه گیری

در ایجاد Robots.txt به یاد داشته باشید، که همواره باید فایل های خود را تست و بررسی کنید. تا بخش مهمی از سایت شما مسدود نشده باشد.

از اینکه در این آموزش نیز همراه ما بودید از شما ممنونیم، امیدواریم این عنوان در بهبود عملکرد تان موثر واقع شده باشد. در مقاله های بعدی همراه آذرسیس باشید.

آیا می توان روبات txt را حذف کرد؟

بله، شما می توانید محتویات قالب را حذف کرده، و قوانین ساده مورد نظر خود را جایگزین آن کنید.